Sedikit lebih dari sebulan telah berlalu sejak rilis OLEG AI - bot saya, yang merekomendasikan posting dari halaman publik Telegram .

Berikut adalah posting sebelumnya, di mana saya menjelaskan subjek secara rinci: Analog feed Facebook untuk Telegram. OLEG AI bodoh

Setelah rilis dan habraeffect berikutnya (begitu kata mereka?), Oleg menerima beberapa ratus pengguna baru, beban, dan kumpulan data perkiraan nyata.

Dan saya mendapatkan pemahaman bahwa model rekomendasi perlu sedikit diubah dan kebocoran memori harus ditangani.

Model rekomendasi

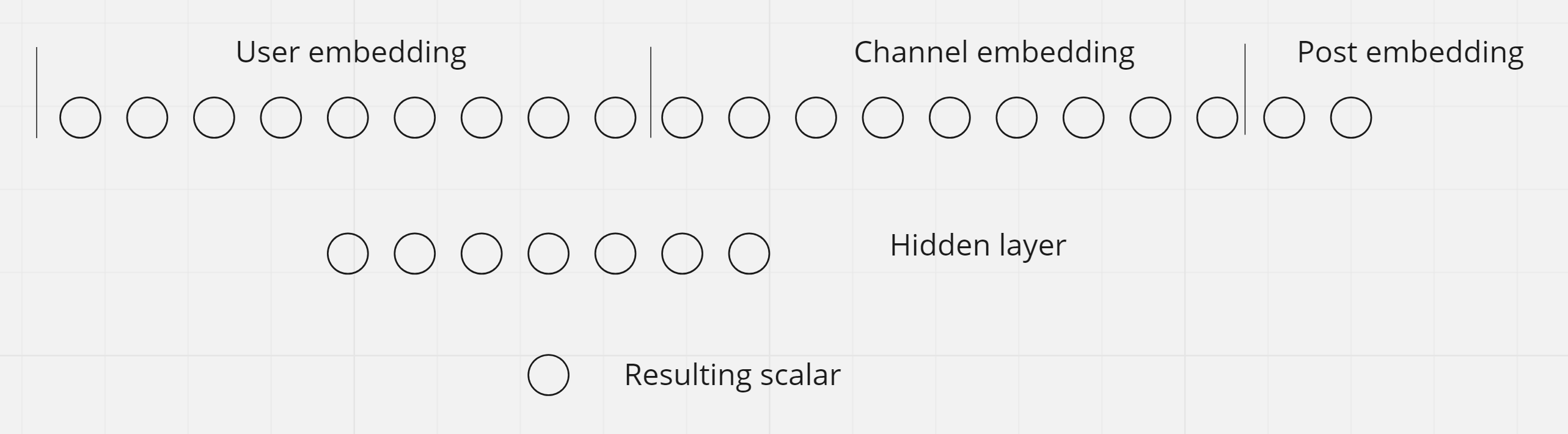

Dalam artikel sebelumnya, saya menulis bahwa saya memutuskan untuk meninggalkan jaringan saraf dalam model, karena model yang didasarkan pada produk vektor penyematan belajar lebih cepat dan kurang rentan terhadap overfitting. Setelah menggunakan model yang agak lama dan mengumpulkan umpan balik dari pengguna pertama, menjadi jelas bagi saya bahwa model tersebut masih perlu sedikit lebih rumit.

Setelah melakukan beberapa penelitian, saya sampai pada kesimpulan bahwa saya perlu mengerjakan hal-hal berikut:

Ajarkan model untuk membedakan saluran

Model lama tidak tahu apa-apa tentang saluran, karena setiap postingnya unik. Saya pikir sebagai hasil dari menandai posting dengan suara pengguna, posting dari satu saluran akan menerima penyematan serupa. Tetapi setelah melihat lebih dekat pada masalah ini, saya menyadari bahwa ini tidak akan terjadi, karena akan selalu ada lebih banyak posting daripada pengguna, yang berarti bahwa ruang posting akan ditandai dengan perkiraan yang jarang. Tidak semua posting akan mendapatkan setidaknya satu peringkat, dan untuk mempertimbangkan posting yang ditandai dengan baik, perlu 10-100 peringkat.

? . flavour (), . , 80% 20% - .

, , DotProduct , . !

, , , . 100, - 80, - 20. , , . 10 (10-8-2) . (100-80-20) - . .

70 1 , .

, , , , , .

, - , 13 .

.

, learning rate. , , , () (). .

, , : , , , .

, :

- 100,

- 80,

- 20

, , , . , + . . , , = 70. , , , , .

DigitalOcean 1 , , . , . , , :)

, , (10-50 ). . , , . , , . , - . , .

, . - restart: on-failure

, out-of-memory, , .

, . , - . , , , . PyTorch append , , . PyTorch, ().

Sekarang Olezhka membutuhkan 4 GB dan CPU Bersama. Jika seseorang memberi tahu Anda bahwa ML membutuhkan rak dengan 8 GPU khusus - ludahi wajahnya. Omong- omong, ini sering dikatakan oleh Jeremy Howard , pencipta kursus fast.ai.