Saat ini, salah satu tren dalam studi jaringan syaraf tiruan grafik adalah analisis pengoperasian arsitektur tersebut, perbandingan dengan metode nuklir, penilaian kompleksitas dan kemampuan generalisasi. Semua ini membantu untuk memahami titik lemah dari model yang ada dan menciptakan ruang untuk model baru.

Pekerjaan ini bertujuan untuk menyelidiki dua masalah yang berkaitan dengan jaringan saraf grafik. Pertama, penulis memberikan contoh grafik yang berbeda strukturnya, tetapi tidak dapat dibedakan untuk GNN yang sederhana dan yang lebih kuat . Kedua, mereka mengikat kesalahan generalisasi untuk grafik jaringan saraf lebih akurat daripada batas VC.

pengantar

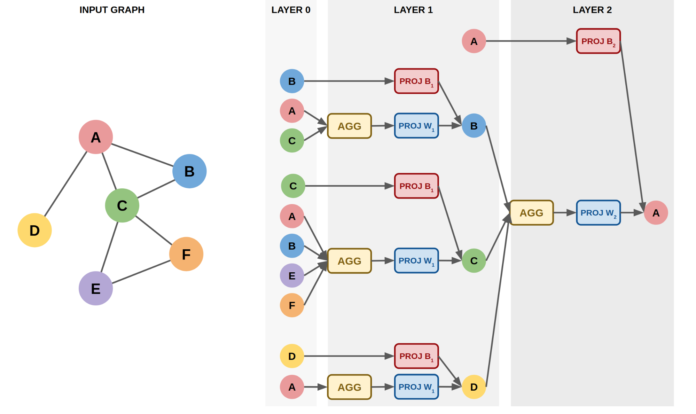

Jaringan neural grafik adalah model yang bekerja langsung dengan grafik. Mereka memungkinkan Anda untuk memperhitungkan informasi tentang struktur. GNN tipikal menyertakan sejumlah kecil lapisan yang diterapkan secara berurutan, memperbarui representasi simpul di setiap iterasi. Contoh arsitektur populer: GCN , GraphSAGE , GAT , GIN .

Proses memperbarui embeddings vertex untuk arsitektur GNN apa pun dapat diringkas dengan dua rumus:

dimana AGG biasanya merupakan fungsi yang tidak berubah terhadap permutasi ( jumlah , rata-rata , maks , dll.), GABUNGKAN adalah fungsi yang menggabungkan representasi simpul dan tetangganya.

Arsitektur yang lebih maju dapat mempertimbangkan informasi tambahan seperti fitur tepi, sudut tepi, dll.

Artikel ini membahas kelas GNN untuk masalah klasifikasi grafik. Model ini disusun seperti ini:

Pertama, simpul adalah embeddings menggunakan langkah-langkah L dari konvolusi graf

(, sum, mean, max)

GNN:

(LU-GNN). GCN, GraphSAGE, GAT, GIN

CPNGNN, , 1 d, d - ( port numbering)

DimeNet, 3D-,

LU-GNN

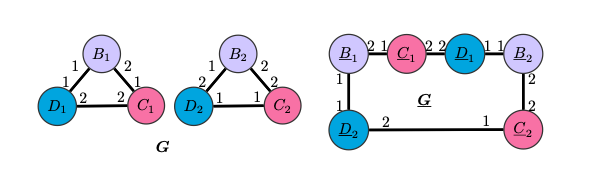

G G LU-GNN, , , readout-, . CPNGNN G G, .

CPNGNN

, “” , CPNGNN .

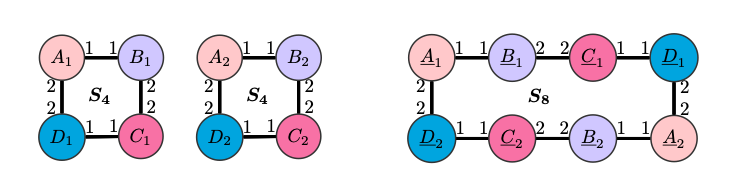

S8 S4 , , ( ), , , CPNGNN readout-, , . , .

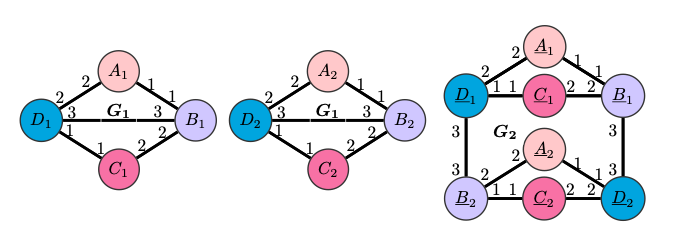

CPNGNN G2 G1. , DimeNet , , , ,

.

DimeNet

DimeNet G4 , G3, . , . , G4 G3 S4 S8, , , DimeNet S4 S8 .

GNN

. , , .

GNN, :

DimeNet

message-

, c - i- v, t - .

:

readout-

.

: LU-GNN,

- ,

- v, ,

. ,

,

.

GNN.

.

.

- GNN

,

- ,

.

, ,

- :

GNN

:

, , , , GNN . , (GNN, ), , , .

, :

,

( )

RNN

- “ ”:

, r - , d - , m - , L - ,

- ,

, ,

GNN, ( readout-), . , , .

( ), . , , , , , , .

Bukti dan informasi lebih rinci dapat ditemukan dengan membaca artikel asli atau dengan melihat laporan dari salah satu penulis.