AI belajar menghasilkan gambar dari tanda tangan dan mulai lebih memahami dunia kita

Dari semua model kecerdasan buatan, itu adalah GPT-3 OpenAI yang paling banyak menangkap imajinasi publik. Dia, tanpa banyak disuruh, bisa memuntahkan puisi, cerita pendek, dan lagu, membuat Anda berpikir bahwa ini adalah karya seseorang. Tetapi kefasihan berbicara hanyalah tipu muslihat dan tidak boleh disamakan dengan kecerdasan yang sebenarnya.

Namun, para peneliti percaya bahwa teknik yang sama yang digunakan untuk membuat GPT-3 menyembunyikan rahasia untuk menciptakan AI yang lebih canggih . GPT-3 dilatih tentang sejumlah besar informasi teks. Bagaimana jika teknik yang sama dilatih secara bersamaan pada teks dan gambar?

Sebuah studi baru yang disebut AI2 dari Paul Allen Institute for Artificial Intelligence telah membawa ide ini ke level berikutnya. Para peneliti telah menciptakan model linguistik visual yang khusus. Ia bekerja dengan teks dan gambar dan dapat menghasilkan yang terakhir dari tanda tangan. Gambar terlihat mengganggu dan aneh, sama sekali tidak seperti deepfake hiperrealistik yang dibuat oleh jaringan adversarial generatif (GAN). Tapi mereka bisa menunjukkan arah baru untuk kecerdasan yang lebih praktis, dan mungkin membuat robot lebih pintar.

Isi celahnya

GPT-3 termasuk dalam kelompok model yang dikenal sebagai "transformer". Mereka pertama kali mendapatkan popularitas berkat keberhasilan BERT, algoritme Google. Sebelum BERT, model bahasa sangat buruk. Kemampuan prediksi mereka cukup untuk pelengkapan otomatis, tetapi tidak untuk menyusun kalimat panjang, di mana aturan tata bahasa dan akal sehat diamati.

BERT mengubah situasi dengan memperkenalkan teknik baru yang disebut masking ( catatan - nama aslinya adalah masking). Ini menyiratkan bahwa kata-kata yang berbeda bersembunyi dalam kalimat, dan model harus mengisi celah tersebut. Contoh:

- Wanita itu pergi ke ___ untuk berlatih.

- Mereka membeli ___ roti untuk membuat sandwich.

Idenya adalah jika Anda memaksa model untuk melakukan latihan ini, sering kali jutaan kali, model akan mulai menemukan pola bagaimana kata-kata disusun menjadi kalimat dan kalimat dirangkai menjadi paragraf. Alhasil, algoritme menghasilkan dan menginterpretasikan teks dengan lebih baik, sehingga semakin dekat untuk memahami makna bahasa tersebut. (Google sekarang menggunakan BERT untuk memberikan hasil pencarian yang lebih relevan.) Setelah masking terbukti sangat efektif, peneliti mencoba menerapkannya pada model bahasa visual dengan menyembunyikan kata dalam tanda tangan. Lewat sini:

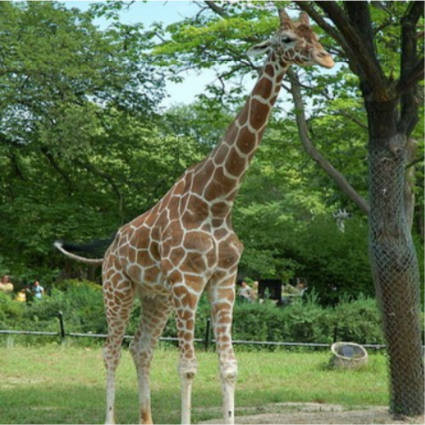

____ berada di atas tanah di samping pohon. Sumber: AI2

Kali ini, model dapat melihat kata-kata di sekitarnya dan konten gambar untuk mengisi celah tersebut. Setelah sejuta pengulangan, dia belajar mendeteksi tidak hanya pola kata, tetapi juga hubungan kata dengan elemen setiap gambar.

Hasilnya, model dapat menghubungkan hubungan tekstual dengan contoh visual tentang bagaimana bayi menghubungkan antara kata-kata yang dipelajari dan hal-hal yang mereka lihat. Model dapat mengambil foto di bawah dan mengumpulkan teks yang bermakna, seperti "Wanita bermain hoki lapangan". Atau mereka mungkin menjawab pertanyaan seperti "Apa warna bola itu" dengan mengaitkan kata "bola" dengan objek melingkar di foto.

Seorang model bahasa visual dapat membuat keterangan yang bermakna untuk foto ini: "Wanita bermain hoki lapangan." Sumber: JOHN TORCASIO / UNSPLASH

Lebih baik lihat gambar sekali

Para peneliti ingin mengetahui apakah model-model ini mengembangkan pemahaman konseptual tentang dunia visual. Seorang anak yang telah mempelajari sebuah kata untuk suatu objek tidak hanya dapat menamainya, tetapi juga menggambar objek tersebut sesuai petunjuk, bahkan jika objek itu sendiri tidak ada. Jadi tim proyek AI2 menyarankan agar model melakukan hal yang sama: menghasilkan gambar dari teks. Semua model menghasilkan sampah piksel yang tidak berarti.

Apakah ini seekor burung? Ini pesawat? Tidak, ini omong kosong, dihasilkan oleh kecerdasan buatan. Sumber: AI2

Ini masuk akal: mengonversi teks menjadi gambar lebih sulit daripada melakukan sebaliknya. “Tanda tangan tidak mendefinisikan semua yang ada di gambar,” kata Ani Kembhavi, Ketua Tim Computer Vision AI2. Jadi, model tersebut harus memanfaatkan sejumlah besar pengetahuan tentang dunia kita untuk menambahkan detail yang hilang.

Misalnya, jika seorang model diminta menggambar "jerapah berjalan di sepanjang jalan", dia harus menyimpulkan bahwa jalan tersebut akan berwarna abu-abu, bukan merah muda cerah, dan akan lewat di sebelah lapangan, bukan ke laut. Meskipun semua informasi ini tidak eksplisit.

Jadi Kembhavi dan rekan-rekannya Jemin Cho, Jiasen Lu, dan Hannane Hajishirzi memutuskan untuk melihat apakah mereka dapat mengajarkan model semua pengetahuan visual tersembunyi ini dengan mengubah pendekatan untuk masking. Alih-alih melatih algoritme untuk sekadar memprediksi kata-kata "bertopeng" dalam keterangan foto yang sesuai, mereka juga melatihnya untuk memprediksi piksel "bertopeng" dalam foto berdasarkan keterangan yang sesuai.

Gambar akhir yang dibuat oleh model tidak sepenuhnya realistis. Tapi itu tidak penting. Mereka berisi konsep visual tingkat tinggi yang benar. AI bertindak seperti anak kecil yang menggambar tongkat untuk mewakili seseorang. (Anda dapat menguji sendiri modelnya di sini ).

Contoh gambar yang dihasilkan oleh model AI2 dari teks. Sumber: AI2

Kemampuan model bahasa visual untuk menghasilkan gambar semacam ini merupakan langkah maju yang penting dalam penelitian kecerdasan buatan. Hal ini menunjukkan bahwa model tersebut sebenarnya mampu mencapai tingkat abstraksi tertentu - keterampilan mendasar untuk memahami dunia.

Dalam jangka panjang, keterampilan tersebut dapat memiliki implikasi penting bagi robotika. Semakin baik robot memahami lingkungan dan menggunakan bahasa untuk mengkomunikasikannya, semakin kompleks tugas yang dapat dilakukannya. Dalam jangka pendek, kata Hajishirzi, visualisasi akan membantu peneliti lebih memahami apa yang dipelajari model, yang sekarang berfungsi seperti kotak hitam.

Di masa mendatang, tim berencana untuk bereksperimen lebih banyak, meningkatkan kualitas pembuatan gambar, dan memperluas visual serta kosakata model: untuk memasukkan lebih banyak topik, objek, dan kata sifat.

“Penciptaan gambar benar-benar bagian dari teka-teki yang hilang,” kata Lu. "Dengan menambahkannya, kita bisa mengajarkan model untuk lebih memahami dunia kita."