Perenderan real-time untuk realitas virtual menciptakan spektrum tantangan yang unik, yang utama adalah kebutuhan untuk mendukung efek fotorealistik, mencapai resolusi tinggi, dan meningkatkan kecepatan refresh. Untuk mengatasi tantangan ini, peneliti Facebook Reality Labs mengembangkan DeepFocus , mesin rendering yang kami perkenalkan pada Desember 2018; itu menggunakan AI untuk membuat grafik ultra-realistis dalam perangkat panjang fokus variabel. Pada konferensi virtual SIGGRAPH tahun ini , kami mempresentasikan pengembangan lebih lanjut dari pekerjaan ini, membuka tonggak baru dalam perjalanan kami menuju tampilan definisi tinggi masa depan untuk VR.

Artikel teknis kami untuk SIGGRAPH berjudul " Neural Supersampling for Real-Time Rendering " memberikan solusi pembelajaran mesin yang mengonversi gambar masuk resolusi rendah menjadi gambar resolusi tinggi untuk rendering waktu nyata. Proses upsampling ini menggunakan jaringan neural yang dilatih pada statistik adegan untuk memulihkan detail yang akurat, sekaligus mengurangi biaya komputasi untuk merender detail tersebut dalam aplikasi waktu nyata.

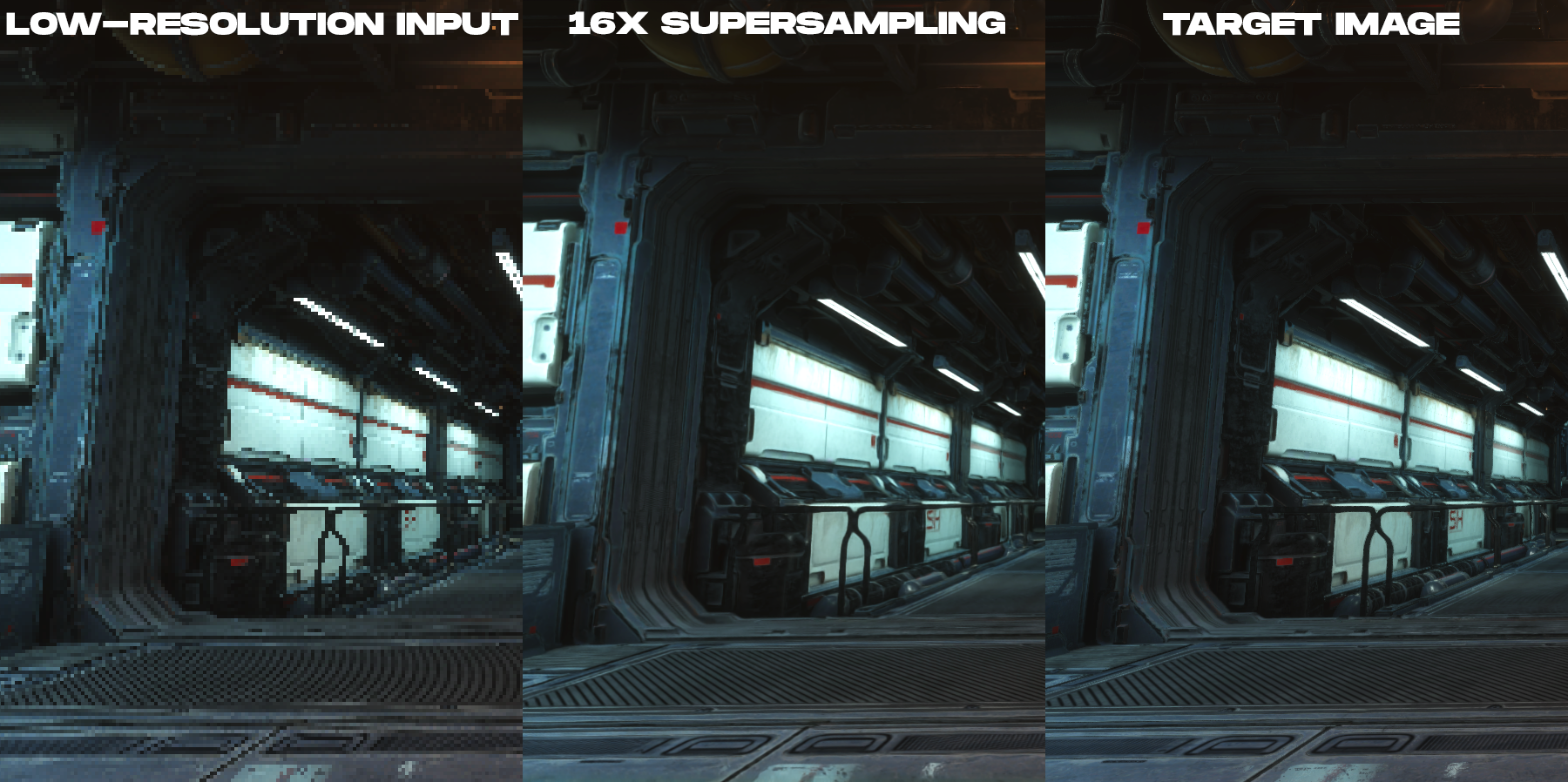

Solusi kami adalah teknik supersampling terlatih yang mencapai 16x supersampling konten untuk rendering dengan ketepatan spasial dan temporal tinggi, jauh mengungguli pekerjaan sebelumnya.

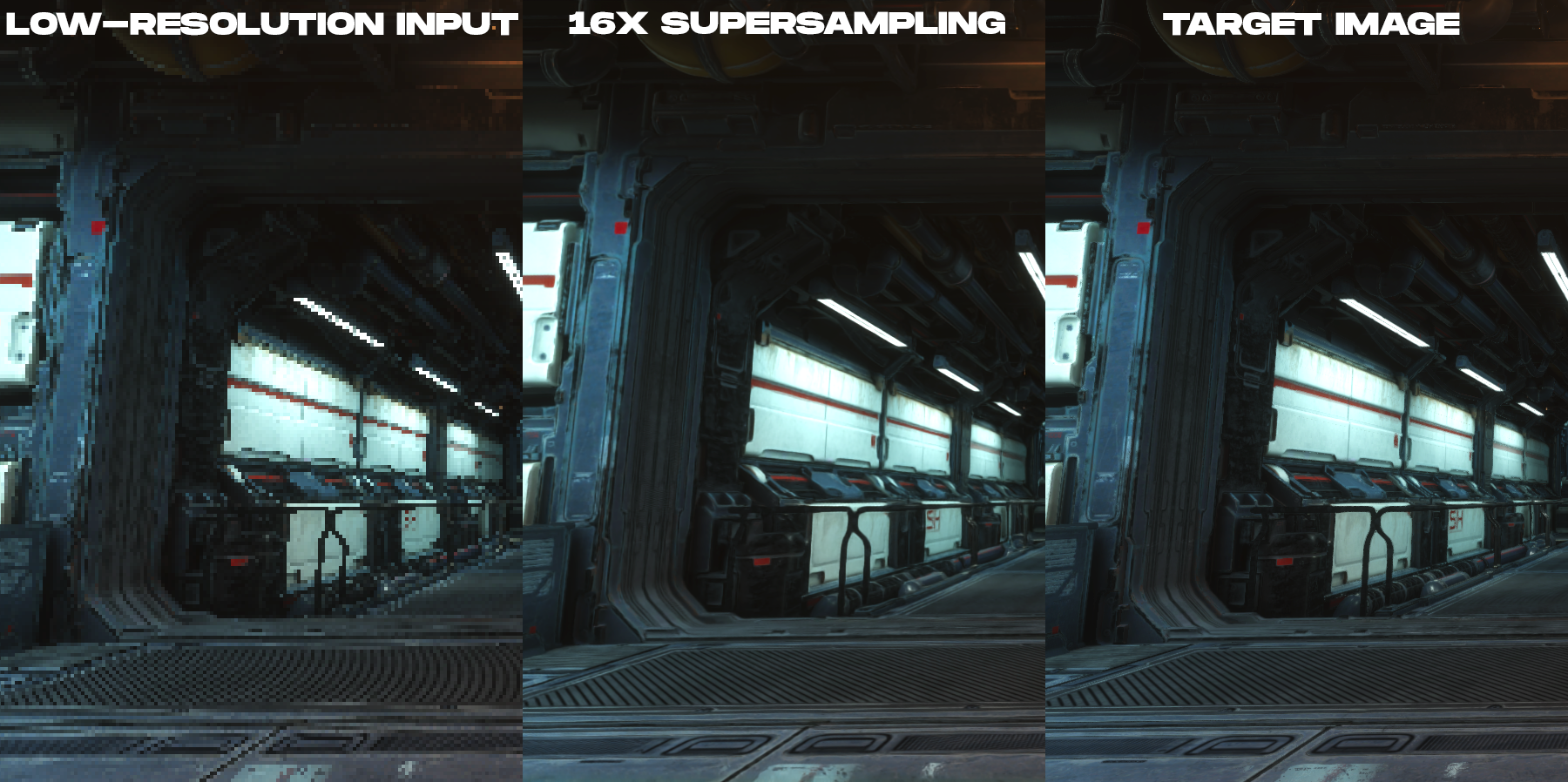

Animasi untuk membandingkan gambar berwarna resolusi rendah yang dirender dan gambar keluaran supersampling 16x yang dibuat dengan teknik neural supersampling baru.

Tentang apa studi ini?

Untuk mengurangi biaya rendering pada tampilan resolusi tinggi, metode kami mengambil gambar masukan yang memiliki piksel 16 kali lebih sedikit daripada gambar keluaran yang diinginkan. Misalnya, jika tampilan target memiliki resolusi 3840 × 2160 , jaringan memulai dengan ukuran gambar masukan 960 × 540 , mesin permainan otrendernnogo, dan kemudian melakukan upampling ke resolusi tampilan yang diinginkan secara real-time pasca-pemrosesan.

Meskipun ada banyak sekali penelitian yang dilakukan tentang upampling berbasis pembelajaran dari gambar fotografi, tidak satu pun dari pekerjaan ini yang secara langsung membahas kebutuhan unik dari konten yang dirender seperti gambar yang dihasilkan oleh mesin video game. Ini karena ada perbedaan pencitraan mendasar antara gambar yang dirender dan fotografis. Dalam rendering waktu nyata, setiap sampel adalah satu titik dalam ruang dan waktu. Inilah sebabnya mengapa konten yang dirender cenderung memiliki distorsi parah, garis bergerigi, dan artefak pengambilan sampel lainnya yang terlihat pada contoh gambar resolusi rendah di posting ini. Karena itu, upampling konten yang dirender menjadi tugas anti-aliasing dan interpolasi, bukan tugas menghilangkan noise dan blur.yang dipelajari dengan baik oleh para ahli computer vision. Fakta bahwa gambar yang masuk sangat terdistorsi dan sama sekali tidak ada informasi untuk interpolasi dalam piksel menciptakan kesulitan yang signifikan dalam membangun rekonstruksi yang sangat akurat dari konten yang dirender dengan integritas temporal.

, ( , ), .

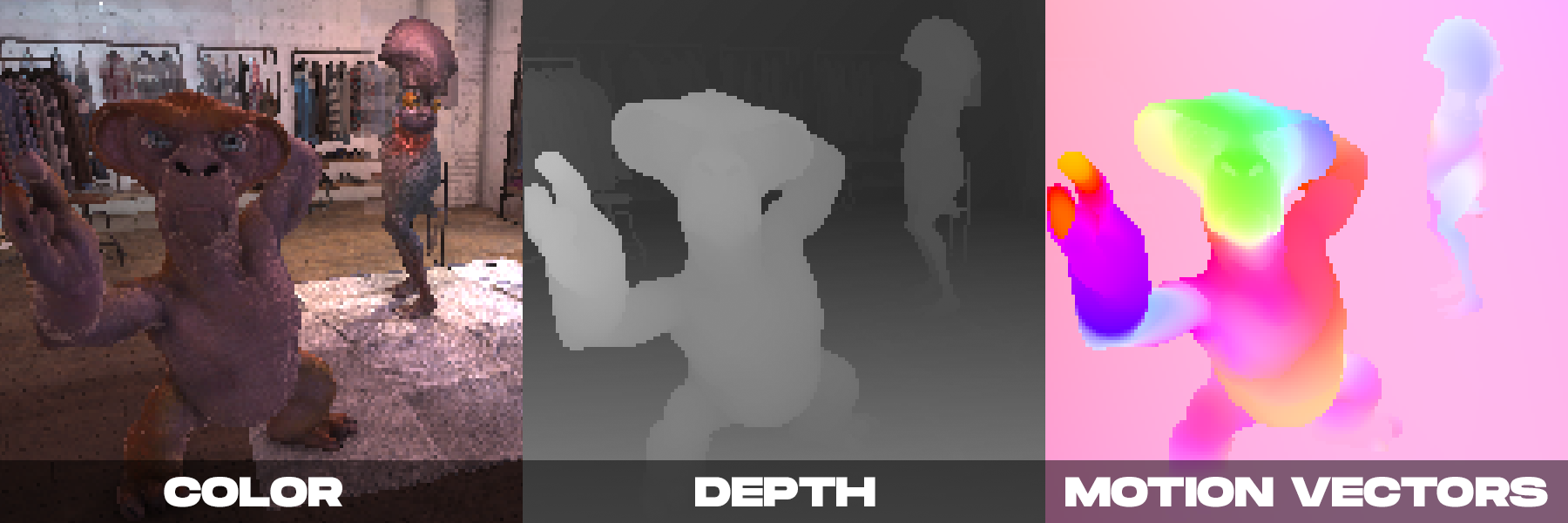

Di sisi lain, saat rendering dalam waktu nyata, kami mungkin memiliki beberapa gambar berwarna yang dihasilkan oleh kamera. Seperti yang kami tunjukkan di DeepFocus, mesin rendering modern juga menyediakan informasi tambahan seperti nilai kedalaman. Kami memperhatikan bahwa dengan supersampling neural, informasi tambahan tambahan yang disediakan oleh vektor gerakan sangat penting. Vektor gerak menentukan hubungan geometris antara piksel dalam bingkai yang berurutan. Dengan kata lain, setiap vektor gerakan menunjuk ke lokasi sub-piksel di mana titik permukaan yang terlihat dalam satu bingkai mungkin berada di bingkai sebelumnya. Untuk gambar fotografi, nilai seperti itu biasanya dihitung menggunakan metode computer vision, tetapi algoritme untuk menghitung gerakan optik rentan terhadap kesalahan.Sebaliknya, mesin rendering dapat menghasilkan vektor gerakan padat secara langsung, sehingga memberikan masukan yang andal dan memadai untuk supersampling neural yang diterapkan pada konten yang dirender.

Metode kami didasarkan pada pengamatan di atas, menggabungkan informasi tambahan dengan skema jaringan saraf spatio-temporal baru yang dirancang untuk memaksimalkan kualitas gambar dan video sekaligus memberikan kinerja waktu nyata.

Saat membuat keputusan, jaringan neural kami menerima sebagai masukan atribut rendering (warna, peta kedalaman, dan vektor gerakan padat dari setiap frame) dari frame saat ini dan beberapa frame sebelumnya, yang dirender pada resolusi rendah. Keluaran jaringan adalah gambar berwarna beresolusi tinggi yang sesuai dengan bingkai saat ini. Jaringan menggunakan pembelajaran yang diawasi. Selama pelatihan, dengan setiap frame resolusi rendah yang masuk, gambar referensi resolusi tinggi dengan metode anti-aliasing dicocokkan, yang merupakan gambar target untuk pengoptimalan pelatihan.

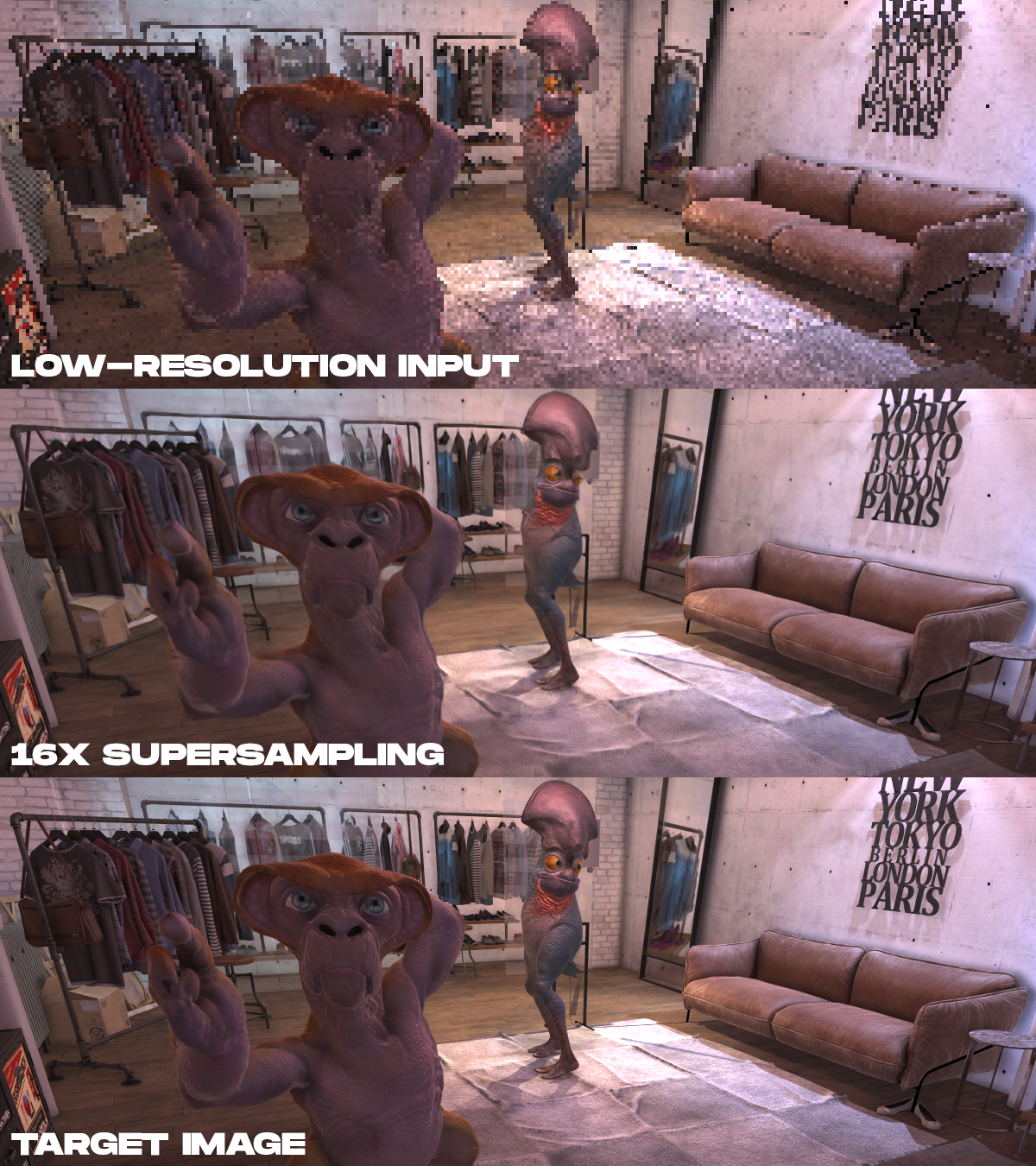

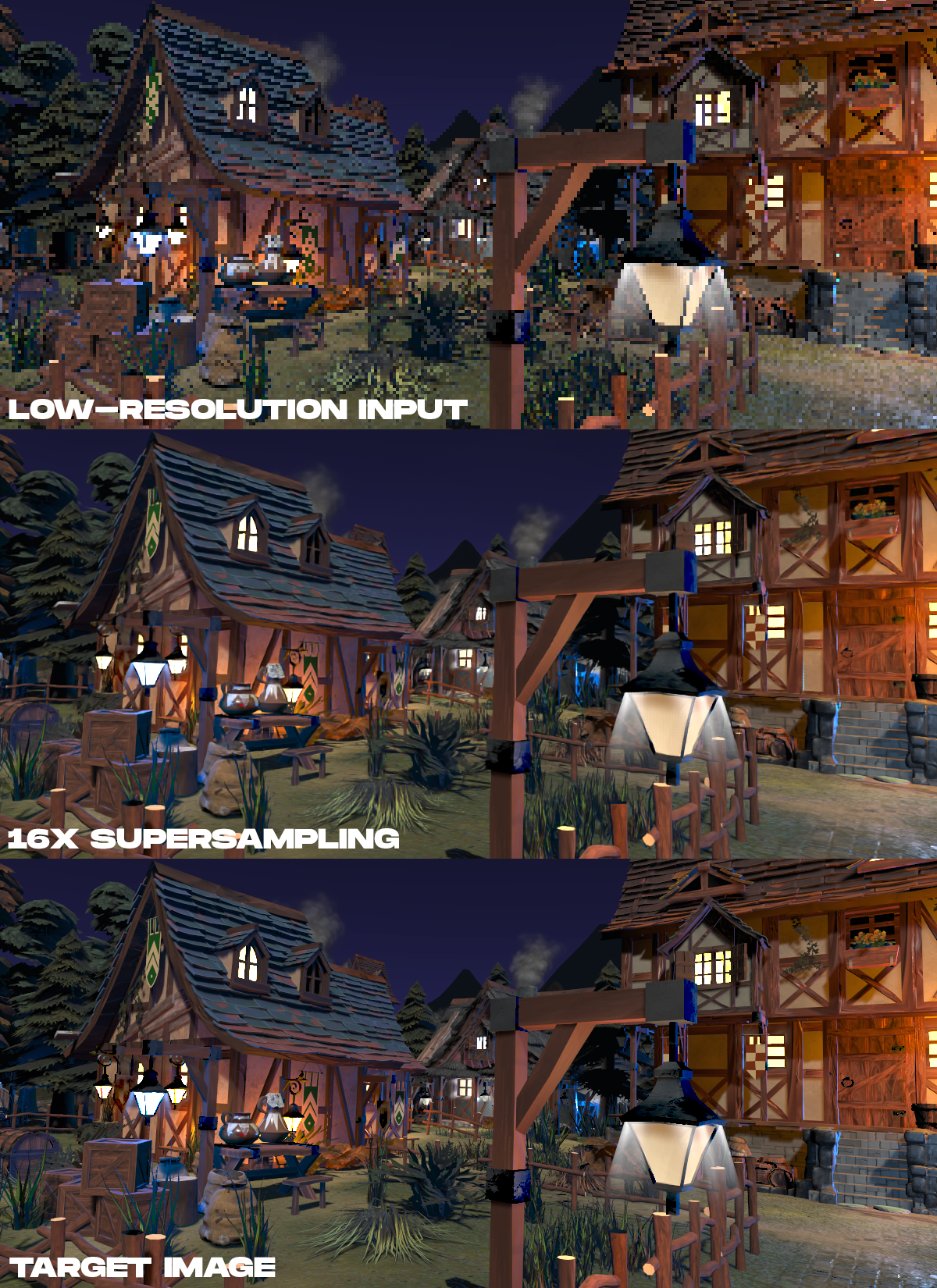

Contoh hasil. Dari atas ke bawah, data warna masukan yang dirender ditampilkan pada resolusi rendah, hasil supersampling sebanyak 16 kali dilakukan dengan metode yang diusulkan, dan gambar target resolusi tinggi, yang dirender secara non-real time.

. , 16 , , , .

. , 16 , , , .

?

Perenderan saraf memiliki potensi luar biasa dalam AR / VR. Meskipun tugas ini sulit, kami ingin menginspirasi peneliti lain untuk mengerjakan topik ini. Karena produsen tampilan untuk AR / VR berusaha keras untuk resolusi yang lebih tinggi, frekuensi gambar yang lebih tinggi, dan fotorealisme, teknik supersampling saraf dapat menjadi cara utama untuk memulihkan detail yang akurat dari data adegan, daripada rendering langsung. Pekerjaan ini membuat kami memahami bahwa masa depan VR definisi tinggi tidak hanya terletak pada tampilan, tetapi juga pada algoritme yang diperlukan untuk mendorongnya secara praktis.

Artikel teknis lengkap: Neural Supersampling for Real-time Rendering , Lei Xiao, Salah Nouri, Matt Chapman, Alexander Fix, Douglas Lanman, Anton Kaplanyan, ACM SIGGRAPH 2020.

Lihat juga: